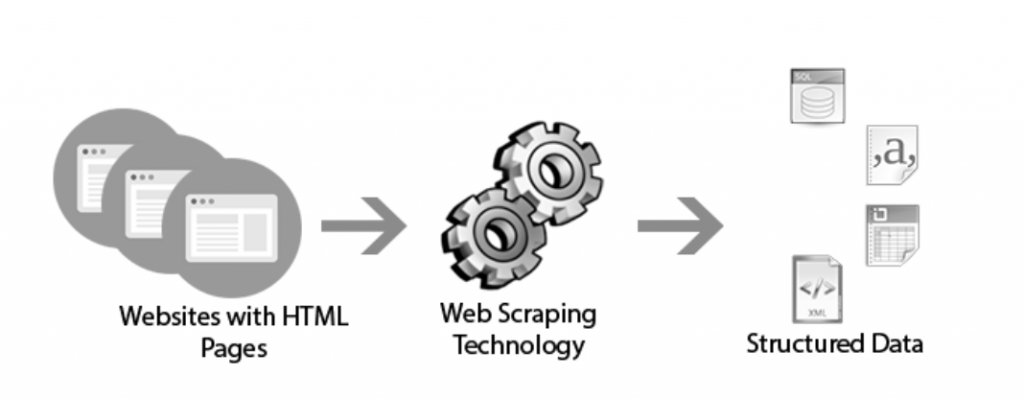

Définition Scraping de données

Le scraping est une technique d’extraction automatique des données d’un ou plusieurs sites web. Cette technique peut être effectuée à l’aide d’un logiciel, d’un outil ou d’une application, mais elle peut aussi être réalisée par des développeurs. La force de cette technique réside dans le fait qu’elle permet d’extraire des datas en grande quantité de façon structurée.

Pourquoi scraper des données en ligne ?

Le web scraping est une technique de récolte rapide de données en ligne. Si cette technique est essentiellement utilisée par les équipes marketing et commerciale des entreprises, le scraping peut servir les différentes équipes de votre entreprise :

- Scraper des données pour le marketing : vous pouvez scraper des annuaires, des sites web de réseaux, des comptes sur Linkedin par exemple pour récolter de nouveaux leads froids.

- Scraper des données pour les commerciaux : vous pouvez scraper des listes de clients de concurrents pour faire du cold mailing ou du social selling par exemple.

- Scraper des données pour les développeurs : vous pouvez scraper des catalogue de site e-commerce pour analyser la structure des sites concurrents par exemple.

- Scraper des données pour les ressources humaines : vous pouvez scraper des offres d’emploi pour positionner vos offres sur la concurrence et analyser les rythmes de recrutement de la concurrence.

Le scraping de données permet de gagner un temps précieux en automatisant la récolte de données en grande quantité pour les analyser et comparer. Cette méthode permet aussi de rentabiliser certaines actions menées par les équipes marketing du fait du volume potentiellement atteignable grâce à la quantité de données amassée (dans le cas d’un mailing envoyé à une base de données par exemple). Enfin, et non des moindres, le scraping permet à toutes les entreprises de trouver de nouveaux leads froids en grande quantité, qu’il faudra certes réchauffer et rassurer pour espérer les convertir.

Quelles données scraper ?

Techniquement, vous pouvez scraper toutes les données présentes sur internet. On distingue trois grandes catégories :

- Les contenus de site internet : toutes les données concernant les prix, les listings produits, les descriptions d’un site e-commerce. Les contenus d’articles, les images de médias ou blog (ne faites pas ça sur Wydden, on vous voit). Toutes les datas comme les adresses mails, les numéros de téléphone et autres informations que l’on peut trouver dans les mentions légales par exemple.

- La data sur des applications : par exemple, comment ne pas scraper Linkedin quand on fait du BtoB pour enrichir sa base de données de prospects et essayer de toucher des clients de concurrents ou autres. Vous trouverez les contacts, les mails, les entreprises, les informations sur les entreprises, bref une mine d’or. La méthode s’applique aussi sur Instagram ou encore sur Indeed.

- Les comportements et la réputation : en scrapant les résultats des Google, les sites d’avis, les tendances sur les réseaux sociaux et les top questions sur Quora par exemple, vous pourrez identifier les tendances et les changements de comportements de votre cible.

Comment réussir un scraping en ligne ?

Le processus de scraping est rapide, même très rapide en fonction de l’outil. En revanche, comme toutes les actions automatisées, il est nécessaire de prendre le temps de préparer le scraping.

- Définir l’objectif du scraping : récolte de data pour analyse, obtenir des informations sur les entreprises cibles, trouver de nouveaux leads… ?

- Identifier les sites et/ou applications à scrapper : plutôt des annuaires d’associations ou des comptes Linkedin ? Site e-commerce ou Quora ?

- Créer la structure de données : il faut coucher sur papier les données souhaitées et la structure de résultats attendue. Cela permet de ne pas scraper de données inutiles et de ne pas polluer le document résultat avec des datas non souhaitées.

- Choisir le bon outil : pour scraper un site e-commerce, l’extension Google Chrome Webscrapper sera idéale, en revanche pour aller chercher de nouveaux leads sur Linkedin, PhantomBuster ou Apify seront recommandés.

- Faire un test à petite échelle : Commencez par tester sur une extraction de 10/20 données. Si les résultats sont cohérents et répondent à vos attentes, alors vous pouvez déployer à grande échelle. N’attendez pas 3 heures pour vous rendre compte que la data essentielle pour vous n’est pas scrapée !

- Lancez le scraping : Tout est bon. Feu !

Est-ce légal de scraper des données ?

Le scraping peut-être très utile pour faire du retargeting, trouver des profils de candidat, faire une étude de marché ou faire une étude des prix sur les sites e-commerces. Cependant, est-ce vraiment légal ? Scraper n’est pas illégal en soi. Les informations se trouvent sur internet et sont donc à la disposition de tous. Cependant, elles sont la propriété d’un site ou d’une personne et les données ne sont probablement pas en libre accès. C’est l’utilisation de ces données qui pose problème. La RGPD est venue cadrerPour un usage personnel à titre informatif, le scraping est utile et légal. Mais la réutilisation des données brutes peut paraître peu éthique voir illégale… Lisez les CGV ou les CGU avant d’utiliser des données scrapées.

Les 10 meilleurs outils de scraping

Tous ces outils comportent des versions gratuites et des versions payantes et plus ou moins simples d’utilisation. Il y a des extensions de navigateur pour scraper, des outils de scraping gratuits et des outils payants de scraping. Chaque outil a ses spécificités, il faudra donc bien définir vos objectifs pour choisir le bon outil de scraping.

#1 : Import.io

En première position, on retrouve le très réputé Import.io. Cet outil scrape les données de n’importe qu’elle page web. Import.io permet également d’exporter les données au format CSV. C’est idéal pour scraper un grand nombre de pages rapidement sans coder.

#2 : Scrapy

Scrapy est un framework open source collaboratif qui permet d’extraire les données d’un site web de manière simple et rapide. Développé sous Python, Scrapy dispose d’une grande communauté qui n’hésite pas à créer des modules supplémentaires pour améliorer l’outil.

#3 : Webhose.io

Webhose.io est capable de scraper des données en temps réel à partir de milliers de sites internet. Il est possible d’extraire des données dans plus de 240 langues et d’enregistrer les données dans plusieurs formats.

#4 : Webscraper

Webscraper est une extension disponible sous Google Chrome qui permet d’extraire les données d’un site internet très rapidement. Web Scraper naviguera sur les sites choisis afin d’en extraire toutes les données. Les données collectées peuvent être exportées sous forme de CSV. L’extension vous permet également de scrapper plusieurs sites à la fois ou même les programmer.

#5 : PhantomBuster

Zéro code et des résultats. Voilà la promesse tenue de PhantomBuster. L’outil offre la possibilité d’extraire les données que vous souhaitez, mais aussi de créer des chaînes d’actions pour générer des pistes d’affaires, des audiences de marketing et une croissance globale. Phantombuster vous donne les outils et le savoir-faire nécessaires pour faire croître votre entreprise plus rapidement. Un outil que nous utilisons chez Wydden et que nous vous présentons dans notre formation Growth Marketing.

#6 : Apify

Apify est le guichet unique pour tout ce qui concerne l’extraction de données et les besoins en matière d’automatisation. Apify est un outil complet qui permet de convertir n’importe quel site internet en API pour automatiser la récolte et l’envoi de données.

#7 Scraping Bot

Le scraping ultra simple ! L’API de Scraping Bot est capable de localiser les informations à collecter dans le HTML de la page web sans difficulté pour vous. Après avoir créé votre compte, vous coller simplement l’URL que vous souhaitez collectée et le tour est joué ! Scraping Bot extrait et analyse ensuite les données dans un fichier Json structuré, prêt à l’emploi (facilement convertible en CSV).

#8 : ParseHub

ParseHub permet de naviguer sur un ou plusieurs sites web afin de scraper ses données. Grâce au machine learning, l’application reconnaît les fichiers compliqués et génère un fichier final en fonction du format de données requis. ParseHub est une plateforme mais possède aussi son application sous Windows, Mac OS X et Linux.

#9 : 80legs

80legs est un outil puissant d’exploration de site web, flexible et configurable facilement. Il prend en charge la collecte de données ainsi que l’option de télécharger instantanée lorsque les données sont extraites. Le Web Scraper utiliserait plus de 600 000 domaines et serait utilisé par des géants du web tels que MailChimp et PayPal.

#10 Octoparse

Un des pionniers du scraping web. L’outil Octoparse offre un interface « pointer-cliquer » qui signifie que toute personne qui sait naviguer peut scraper. Aucun code n’est nécessaire. Vous pouvez extraire de données de n’importe quel site web dynamique et récupérer des pages illimitées gratuitement.

Vous avez maintenant une vision globale des outils qui existent, à vous de jouer !

Article publié le 22/08/2017. Dernière mise à jour 12/01/2021. Photo by Fabian Grohs on Unsplash

Formation Growth Marketing

- Automatisez vos processus

- Apprenez à scraper

- Activez vos leviers d’acquisition

- Tracker vos actions